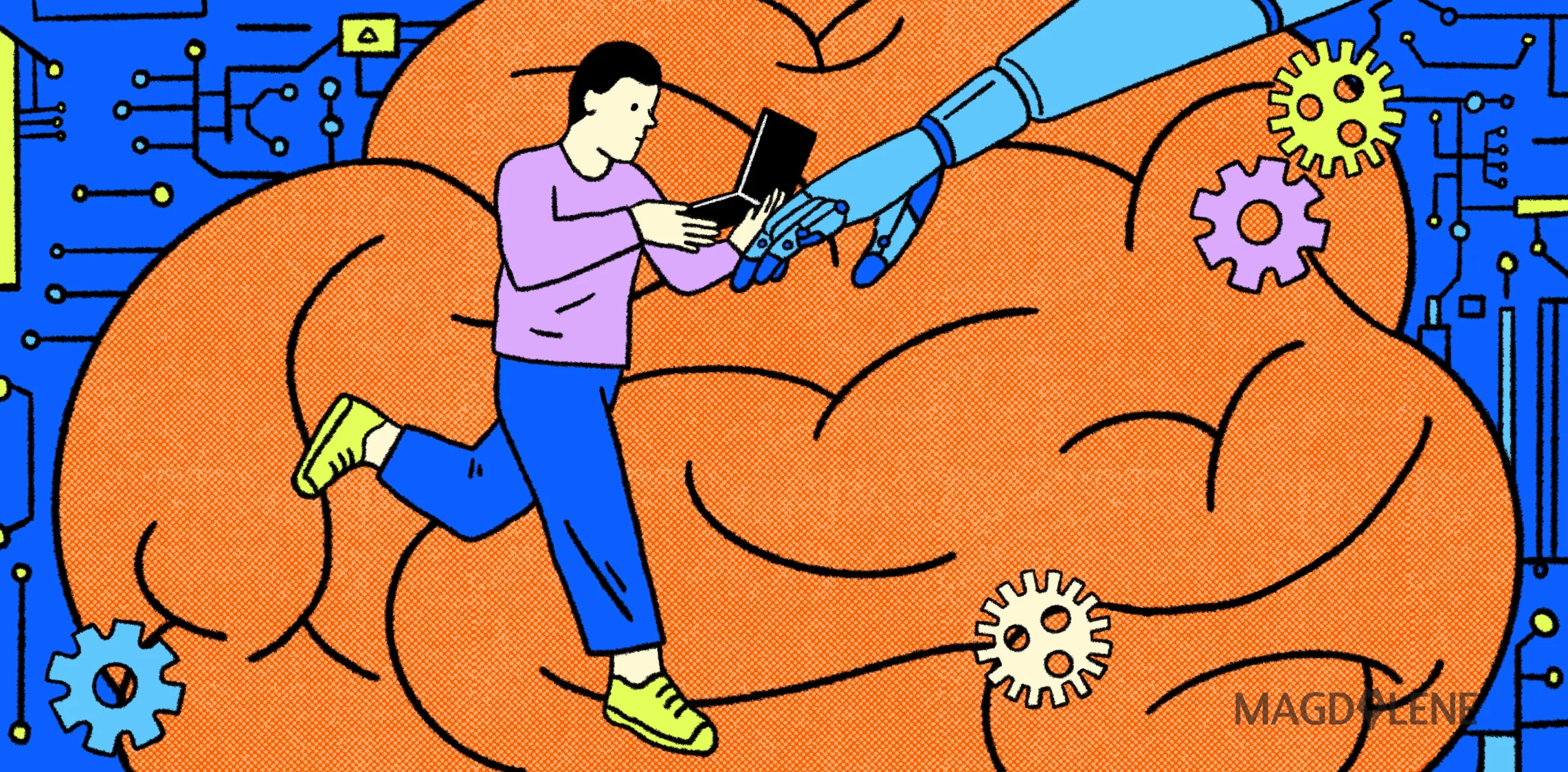

Kerentanan Anak dari Ancaman Pelecehan Seksual Lewat Kecanggihan AI

Materi pelecehan seksual, khususnya yang berkaitan dengan anak (child sexual abuse material/CSAM), merupakan salah satu aspek paling mengerikan dari konten daring. Materi ini tidak hanya melanggar hak dan martabat anak, tetapi juga menimbulkan trauma yang berkepanjangan bagi korban.

Proliferasi gambar dan video terkait CSAM di internet telah menjadi masalah yang persisten. Munculnya kecerdasan artifisial (AI) semakin menambah dimensi baru yang mengkhawatirkan terkait masalah ini. Pasalnya, AI bisa mempercepat distribusi dan penciptaan CSAM.

Baca juga: ‘Deepfake’ Bertebaran di Internet, Bagaimana Bedakan Fakta dari Fiksi AI?

Cara AI Memproduksi CSAM

AI generatif (GenAI), memiliki potensi untuk meningkatkan produksi dan penyebaran materi pelecehan seksual dengan cepat. Model AI, yang dilatih dengan kumpulan data besar yang sering kali mencakup konten eksplisit, dapat membuat gambar dan video pelecehan seksual anak yang realistis dengan sekali klik.

Laporan tentang gambar porno yang dihasilkan AI dari siswa sekolah menengah terus bermunculan di berbagai belahan dunia seperti di Amerika Serikat (AS) dan Spanyol. Pusat Nasional untuk Anak Hilang & Tereksploitasi (National Center for Missing & Exploited Children/NCMEC) di AS, misalnya, melaporkan peningkatan laporan CSAM sebesar 12% pada tahun 2023, dengan total lebih dari 36 juta laporan, dan peningkatan yang signifikan dalam penggunaan GenAI untuk membuat konten tersebut.

Ancaman Serius CSAM yang Dihasilkan AI

Peningkatan CSAM yang dihasilkan GenAI menimbulkan ancaman signifikan karena beberapa alasan. Pertama, ini memudahkan pelaku untuk memproduksi dan mendistribusikan konten eksplisit tanpa melibatkan anak-anak sungguhan, yang mungkin dianggap oleh sebagian orang bukanlah eksploitasi.

Namun, ini adalah kesalahpahaman yang berbahaya. Meskipun gambar-gambar tersebut sintetis, mereka tetap memperkuat budaya eksploitasi seksual dan dapat digunakan untuk merayu dan memanipulasi anak-anak yang sebenarnya.

Kedua, data latih (training data) untuk banyak model AI sering kali mencakup CSAM yang sebenarnya, yang berarti gambar yang dihasilkan AI masih dapat didasarkan pada pelecehan yang nyata. Hal ini tidak hanya menambah trauma korban, tetapi juga membanjiri internet dengan bentuk-bentuk baru materi pelecehan, membanjiri sistem deteksi yang ada dan menyulitkan penegak hukum untuk fokus pada korban yang sebenarnya.

Terlebih lagi, gambar yang dihasilkan oleh AI ini terkadang tidak dapat dibedakan dari foto asli, sehingga menyulitkan upaya penegak hukum untuk mengidentifikasi dan menyelamatkan korban.

Baca juga: Ancaman Deepfake: KBGO dan Gerak Perempuan yang Makin Rentan

Langkah mengatasi penyalahgunaan AI terkait CASM

Mengingat implikasinya yang parah, penting untuk mengambil langkah-langkah proaktif untuk mencegah penyalahgunaan AI dalam membuat dan mendistribusikan CSAM.

Pertama, model AI memerlukan penerapan pengamanan yang kuat di sekitarnya untuk memastikan mereka tidak dapat menghasilkan gambar yang bersifat seksual eksplisit. Ini melibatkan penyaringan data latih untuk mengecualikan segala bentuk konten eksplisit dan memantau output model ini secara terus-menerus.

Kedua, perusahaan AI perlu memprioritaskan keselamatan anak dengan mengintegrasikan sistem deteksi canggih yang dapat mengidentifikasi dan memblokir pembuatan konten pelecehan seksual anak.

Ketiga, penegak hukum perlu memutakhirkan pengetahuan mereka terkait kecanggihan teknologi. Ini akan membantu mereka melakukan investigasi yang lebih baik.

Di Kanada, proyek Aquatic, yang melibatkan 27 layanan kepolisian, menyoroti peningkatan kecanggihan predator yang menggunakan AI untuk menghasilkan CSAM, mengidentifikasi 34 korban anak dan menangkap 64 individu dengan 348 dakwaan.

Keempat, platform yang memuat konten buatan pengguna juga harus meningkatkan kemampuan moderasi konten mereka. Mereka perlu mempekerjakan baik peninjau manusia maupun alat AI untuk mendeteksi dan menghapus CSAM dengan cepat.

Kelima, selain langkah-langkah teknis, perlu ada upaya bersama untuk meningkatkan kesadaran tentang penyalahgunaan AI dalam menghasilkan CSAM. Mendidik orang tua, pendidik, dan anak-anak tentang bahaya konten eksplisit yang dihasilkan AI dapat membantu dalam identifikasi dan pelaporan dini materi semacam itu.

Sebuah survei oleh yayasan Lucy Faithfull mengungkapkan bahwa meskipun 60% orang khawatir tentang AI, hanya 40% yang tahu bahwa gambar seksual yang dihasilkan AI dari anak di bawah umur adalah ilegal di Inggris. Yayasan Lucy Faithfull merupakan badan sosial perlindungan anak-anak di UK yang berupaya menghentikan penyalahgunaan seksual anak-anak.

Keenam, intervensi pemerintah melalui regulasi sangat penting untuk mengatasi krisis ini secara efektif. Legislator harus bekerja sama dengan perusahaan teknologi, organisasi perlindungan anak, dan agen penegak hukum untuk mengembangkan regulasi komprehensif yang menangani penyalahgunaan AI.

Ini termasuk mewajibkan perusahaan AI untuk menerapkan fitur keamanan yang mencegah pembuatan konten eksplisit dan mengharuskan platform media sosial untuk melaporkan dan menghapus CSAM dengan cepat.

Misalnya, pada tahun 2022, Pusat Perlindungan Anak Kanada menandai sekitar 2.600 gambar yang dihasilkan AI, angka yang meningkat menjadi 3.700 pada 2023, dengan ekspektasi setidaknya 6.000 pada 2024.

Regulasi terkait CASM

Di Indonesia, pelecehan seksual daring diatur oleh beberapa kerangka hukum, utamanya Undang-Undang (UU) Tindak Pidana Kekerasan Seksual (UU TPKS) dan UU Informasi dan Transaksi Elektronik (UU ITE).

UU TPKS mencakup pelecehan seksual nonfisik, yang mencakup komentar, gerakan, atau aktivitas yang tidak pantas yang bertujuan merendahkan seseorang secara seksual. Pelanggar dapat menghadapi hukuman penjara hingga 9 bulan atau denda hingga Rp10 juta. Untuk kekerasan seksual berbasis elektronik, seperti perekaman tanpa izin, transmisi konten seksual, atau penguntitan siber, undang-undang ini menjatuhkan hukuman hingga empat tahun penjara atau denda hingga Rp200 juta.

UU ITE melarang distribusi, transmisi, atau membuat informasi elektronik yang mengandung kesusilaan dapat diakses. Pelanggar dapat dijatuhi hukuman penjara hingga enam tahun atau denda hingga Rp1 miliar.

Dalam kasus yang melibatkan anak-anak, regulasi tambahan berlaku. UU Perlindungan Anak (UU TPA) memberikan hukuman berat untuk kejahatan seksual terhadap anak-anak, dengan hukuman penjara maksimal 10 tahun dan denda hingga Rp200 juta. Namun, aturan ini tidak sepenuhnya menangani eksploitasi daring yang diatur oleh UU ITE dan UU Pornografi.

Selain itu, dalam konteks pelecehan seksual terhadap anak, justice-based laws juga dapat diterapkan dengan menekankan pentingnya keadilan substantif. Keadilan substantif adalah keadilan dalam keputusan hakim yang adil, jujur, objektif, tidak memihak, tidak diskriminatif, dan berdasarkan hati nurani.

Hukuman seperti kastrasi kimia diterapkan sebagai hukuman tegas bagi pelaku untuk memberikan efek jera dan perlindungan maksimal bagi korban. Strategi lain termasuk keadilan restoratif dan keterlibatan komunitas untuk pencegahan serta rehabilitasi korban.

Dalam konteks pelecehan seksual, keadilan restoratif berarti memperhatikan kebutuhan korban, memfasilitasi proses pemulihan mereka, mempertimbangkan pertanggungjawaban dan pembelajaran bagi pelaku, serta melibatkan komunitas dalam mendukung proses rekonsiliasi yang holistik.

Pada akhirnya, persimpangan antara AI dan materi pelecehan seksual anak menghadirkan tantangan yang signifikan dan mendesak. Potensi AI untuk menghasilkan dan mendistribusikan konten eksplisit memerlukan tindakan segera dan tegas dari perusahaan teknologi, pemerintah, dan masyarakat secara keseluruhan.![]()

Arif Perdana, Associate Professor in Digital Strategy and Data Science, Monash University

Artikel ini pertama kali diterbitkan oleh The Conversation, sumber berita dan analisis yang independen dari akademisi dan komunitas peneliti yang disalurkan langsung pada masyarakat.